Introduction à la prévision météorologique

PDF

Quel temps aurons-nous le week-end prochain ? Quels sont les risques d’orage, de tempête, de canicule dans les jours qui viennent ? Les services météorologiques sont maintenant capables de répondre à ces questions de manière utile. Mais quelle mécanique se cache derrière ces prévisions ? Cet article présente un panorama du fonctionnement des centres de Prévision Numérique du Temps qui existent dans divers pays du monde, et introduit les notions essentielles développées dans les autres articles de cette sous-rubrique.

1. Introduction

Chaque pays du monde dispose d’un Service Météorologique National (SMN), ayant pour mission est de réaliser des observations régulières de l’atmosphère et d’élaborer des prévisions pour le gouvernement, l’industrie et le public. Mais seuls les pays les plus avancés disposent de centres de Prévision Numérique du Temps (PNT), dont les produits sont également distribués aux autres pays, en échange de leurs observations, dans le cadre de l’Organisation Météorologique Mondiale [1].

Parmi les principaux centres de PNT hors Europe, on peut citer ceux des Etats Unis, du Canada, du Japon, de la Corée, de la Chine, de la Russie, de l’Australie, de l’Inde, du Maroc, de l’Afrique du Sud et du Brésil. En Europe, seule la France, le Royaume Uni et l’Allemagne réalisent des prévisions numériques sur l’ensemble du globe terrestre, tandis que les autres pays ont des centres de PNT ne couvrant que des domaines régionaux. Les pays Européens se sont aussi regroupés dans un « super-centre » [2], chargé de leur fournir des prévisions numériques à moyenne échéance.

2. Les différentes fonctions des centres de PNT

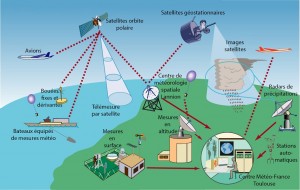

Le système d’observation composite ainsi constitué représente l’essentiel du coût de la météorologie, et ce coût est partagé entre tous les pays du monde. Le fait que les différents pays échangent librement leurs observations (même parfois en temps de guerre) est une des réalisations les plus remarquables de la météorologie.

Le volume de ces données est considérable (des dizaines de millions d’observations chaque jour, réparties sur l’ensemble du globe terrestre) et tout est mis en œuvre pour qu’elles arrivent le plus rapidement possible dans les centres de PNT, en général moins de trois heures après la réalisation de la mesure. Ces centres doivent posséder des systèmes de télécommunication et traitement de l’information puissants pour recevoir, traiter et archiver les observations au fur et à mesure de leur disponibilité.

La deuxième fonction est l’examen critique des observations pour détecter les éventuelles observations fausses (si un système de mesure est défaillant), redondantes, ou biaisées. Cela est généralement fait en comparant des observations voisines, ou bien en comparant chaque observation à une prévision récente du même paramètre (si l’observation est très différente de la prévision, on aura tendance à la considérer comme suspecte, sauf si elle est confirmée par des observations voisines et indépendantes). Les anomalies constatées sur certaines observations sont signalées aux services originaires, qui peuvent alors prendre des mesures correctives.

La troisième fonction consiste à produire, à partir de l’ensemble varié et hétérogène des observations récentes, un « état » de l’atmosphère sous forme de champs mathématiques qui pourront servir à démarrer le modèle de prévision. Cette tâche de production de l’état initial de la prévision a pour nom Assimilation des données (lire « Assimilation des données météorologiques »). On vise naturellement à produire l’état initial le plus proche possible de la réalité à un instant donné, mais cela est très difficile car les observations sont toutes affectées de petites incertitudes, ne sont pas synchrones et ne couvrent pas tous les points du globe. Il faut donc interpoler spatialement et temporellement et rechercher l’état initial « le plus probable » compte tenu de l’ensemble des informations disponibles.

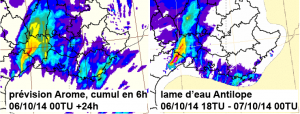

La quatrième fonction est la prévision proprement dite, qui est réalisée par un modèle numérique de l’atmosphère (lire « Modéliser l’atmosphère : une gageure devenue un succès »). Le modèle résout les équations de la dynamique des fluides et calcule les états successifs pour se projeter dans le temps à 24h, 48h, etc… Les principaux centres de PNT utilisent en fait plusieurs configurations des modèles de prévision : une version couvrant l’ensemble du globe pour une prévision générale à échéance de plusieurs jours, puis une ou plusieurs versions « régionales » couvrant des zones d’intérêt particulier, comme leur territoire national ou leurs régions d’outremer, pour une prévision à échéance plus courte et sur une grille de calcul plus fine. A Météo-France, la configuration globale est nommée ARPEGE (Pailleux et al. 2015), et la configuration régionale est nommée AROME (Bouttier, 2007).

De plus en plus, on a tendance à remplacer la prévision déterministe (une seule prévision faite à partir du meilleur état initial possible) par la prévision probabiliste (plusieurs prévisions simultanées faites à partir d’états initiaux un peu différents, pour tenir compte des incertitudes résiduelles de l’état initial). On appelle cela la Prévision d’Ensemble (lire « La prévision d’ensemble »). A partir de ces différentes prévisions, on peut calculer la probabilité que certains événements redoutés ou espérés se produisent.

Enfin, les prévisions des paramètres atmosphériques sont utilisées pour forcer des « modèles d’impact » qui calculent plus précisément l’état de la mer, les débits des fleuves, l’état du manteau neigeux et les risques d’avalanche, la qualité de l’air, l’état des routes, etc…

D’autres systèmes de prévision sont également exploités pour mieux couvrir les très courtes ou les très longues échéances : les systèmes de prévision Immédiate extrapolent les observations jusqu’à quelques heures, avec un rafraichissement très fréquent et sont plus performants que les modèles de PNT pour ces courtes échéances. Une fois par mois, les systèmes de prévision saisonnière calculent les anomalies climatiques probables dans les 3 à 6 mois à venir, avec des résultats de qualité très variable suivant les zones géographiques et les saisons (lire « La prévision saisonnière »). Les modèles de prévision saisonnière sont très voisins, dans leur conception, des modèles de climat utilisés pour les rapports du GIEC [4].

Les résultats bruts de tous les systèmes de prévision sont stockés dans des bases de données au fur et à mesure de leur production, et ces bases de données sont interrogées en permanence par des algorithmes qui alimentent les diverses applications où les utilisateurs trouvent les informations finalisées qu’ils souhaitent (par exemple les sites Internet ou les applications mobiles). Pour les applications les plus sensibles, en particulier tout ce qui a trait à la sécurité des personnes et des biens, les bases de données sont supervisées par un expert prévisionniste. Celui-ci examine la cohérence des prévisions de plusieurs modèles, les observations les plus récentes, et peut décider de déclencher des alertes météo. En France, il s’agit notamment de la procédure de la Carte de Vigilance (lire « Le rôle du prévisionniste »).

La dernière fonction importante d’un centre de PNT est la vérification a posteriori des prévisions. Celle-ci est réalisée en comparant les prévisions aux observations les plus fiables, en accumulant les résultats sur des périodes assez longues pour créer des scores. Les centres de PNT calculent quotidiennement un très grand nombre de scores et échangent entre eux ces informations. Cela permet de connaitre la qualité moyenne des prévisions, de vérifier qu’une nouvelle version d’un système de prévision représente un progrès par rapport à la version antérieure, ou de comparer les performances de deux centres de PNT. Cela permet aussi de vérifier que les évolutions des systèmes d’observation améliorent la qualité de la prévision (par exemple lorsqu’un satellite en fin de vie est remplacé par un satellite d’une génération plus récente). La figure 1 est un exemple de tels scores de prévision.

La qualité des prévisions ayant désormais atteint un degré élevé, il est nécessaire de tester toute modification des systèmes de prévision sur de longues périodes (plusieurs mois) pour être sûr de ne jamais dégrader les prévisions. Il faut de plus tenir compte de la variabilité naturelle de la prévisibilité de l’atmosphère, qui est indépendante de la qualité des systèmes de prévision. Il est bien établi que certains paramètres sont plus faciles à prévoir l’été que l’hiver, ou inversement, mais on constate aussi que l’atmosphère peut se comporter de manière très différente, et plus ou moins prévisible, lors de plusieurs hivers (ou étés) successifs. Cette variabilité lente est un des aspects les plus passionnants de la dynamique de l’atmosphère, encore très mal compris.

3. La qualité des prévisions

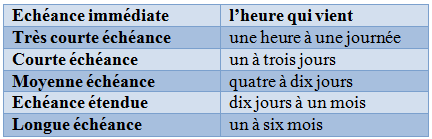

La qualité des prévisions numériques du temps est variable suivant le paramètre considéré et selon l’échéance (voir tableau). Aux échéances courtes la température est en général prévue avec une erreur ne dépassant pas quelques degrés, et le vent avec une erreur ne dépassant pas quelques mètres par secondes, sauf dans les zones orageuses. Pour les précipitations, notamment orageuses, on n’en est pas à ce niveau de qualité, car des petites erreurs sur les quantités précédentes se traduisent par des erreurs plus importantes sur les précipitations.

Prévoir avec précision la localisation précise d’un orage et la quantité de pluie associée ou le risque de grêle reste extrêmement difficile, même quelques heures à l’avance. Il en est de même pour la quantité de neige en hiver, surtout quand la température est proche de 0°C au sol, et qu’une petite erreur de température peut entraîner une erreur sur la nature des précipitations (pluie ou neige). C’est également le cas du brouillard, qui reste très difficile à prévoir, même quelques heures à l’avance, car sa formation dépend de l’humidité qui est très variable. Pour les tornades, on doit se limiter à indiquer un risque d’occurrence.

La qualité des prévisions aux échéances mensuelles à saisonnières est encore très modeste. Dans les régions tropicales, certains phénomènes comme El Niño [5] sont prévisibles plusieurs mois à l’avance. Par contre en Europe, il reste impossible de prévoir la température plus de quelques semaines à l’avance.

4. La puissance de calcul

Les degrés de liberté sont nombreux : le nombre des observations réellement utilisées, la complexité des algorithmes de validation/assimilation des observations, la résolution des modèles de prévision (c’est à dire la finesse de la grille de calcul), la complexité des équations qui peuvent représenter plus ou moins en détail les processus, et la taille des ensembles de prévision (en général les ensembles ont plusieurs dizaines de membres, mais pour certaines applications il pourrait être avantageux de monter à plusieurs centaines). Enfin la répartition de la puissance de calcul entre la prévision atmosphérique et les modèles d’impact demande un examen attentif si l’on veut garantir un résultat final optimal.

Au final, l’heure de démarrage de la production est variable suivant les centres et les produits, d’une dizaine de minutes à plusieurs heures avant l’heure de diffusion.

5. La R&D en prévision

L’amélioration des systèmes de PNT repose sur les départements R&D des SMN, qui coopèrent beaucoup entre eux, mais s’appuient également sur les Universités et les Organismes de Recherche. Il existe encore des enjeux de connaissance importants dans le domaine des processus et de la prévisibilité atmosphériques, avec des bénéfices sociétaux évidents qui justifient que les pouvoirs publics consacrent des ressources importantes à ce sujet (en France, dans les laboratoires des universités et du CNRS notamment). Le développement des systèmes d’observation conduit également à une recherche technologique active, avec des retombées industrielles importantes, notamment dans le domaine spatial, mais aussi pour les radars et les lidars [6] au sol.

Parmi les grandes évolutions observées actuellement (2016), on peut noter tout particulièrement :

– La réécriture profonde des codes pour exploiter au mieux les nouvelles architectures massivement parallèles des calculateurs (problématique de la « scalabilité » [7]).

– Le développement des systèmes de prévision « couplés », dans lesquels on ajoute au modèle de dynamique et physique atmosphérique, un ou plusieurs modules parmi les suivants : surface continentale sous-jacente, dynamique de l’océan et des vagues, composition atmosphérique (espèces chimiques et surtout aérosols). Pour cette raison, les modèles de PNT ressemblent de plus en plus à des modèles de climat, et la plupart des pays cherchent à mutualiser les développements pour la PNT et le climat.

– Le développement des prévisions d’ensemble, qui sont maintenant appliquées non seulement à l’atmosphère, mais aussi aux autres modèles (océan et état de mer, qualité de l’air, hydrologie, manteau neigeux, etc….)

– La précision et le nombre des observations de satellites sont en évolution rapide : on attend en 2017 les premières mesures directes de vent depuis l’orbite terrestre (lidar Doppler ADM-AEOLUS de l’ESA) et en 2020 les premières mesures hyperspectrales dans l’infra-rouge depuis un satellite géostationnaire (Instrument IRS sur Météosat 3e génération). Les mesures des radars météorologiques sont également de plus en plus performantes et variées.

– Des informations indirectes sur l’état de l’atmosphère provenant de sources de plus en plus variées deviennent progressivement disponibles (paradigme des mégadonnées, ou Big Data [8]). Par exemple, la trajectoire des avions commerciaux est analysée pour estimer la vitesse du vent, les perturbations des télécommunications hertziennes donnent des informations sur la pluie, les réseaux GPS donnent des informations sur l’humidité de l’air, les automobiles et les téléphones portables sont maintenant équipés en série de capteurs de température et de pression. La capture de ces nouvelles données et leur utilisation pour améliorer les prévisions sera un des grands enjeux de demain.

– Aux Etats-Unis et en Europe, les SMN s’orientent progressivement vers la distribution gratuite des données brutes de PNT sur Internet (cf. directive PSI [9] en Europe).

– Le secteur privé commence aussi à s’intéresser à la production de PNT, perçue comme une activité pouvant générer des bénéfices. Panasonic et IBM (The WeatherCompany [10]) ont récemment communiqué sur ce thème.

Tableau : les échéances de la prévision météorologique

Références et notes

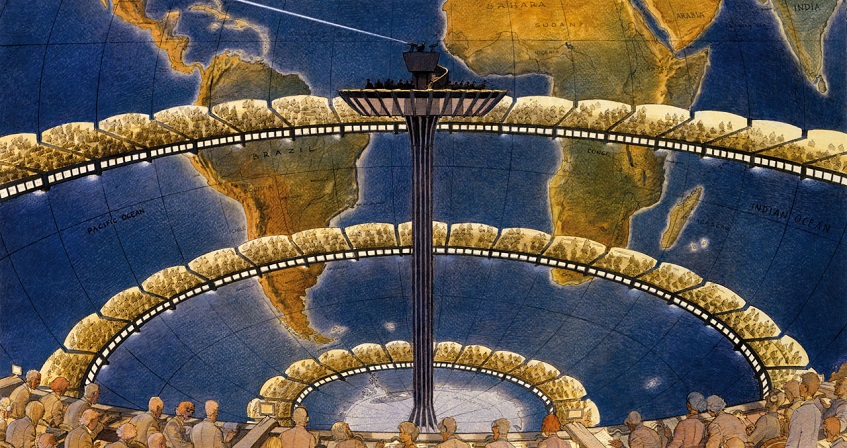

Image de couverture : Dès 1922, un savant anglais, Lewis Fry Richardson, a pensé qu’il serait un jour possible de calculer l’écoulement atmosphérique suffisamment vite pour faire des prévisions. Il imaginait une « usine de calcul » où des centaines de mathématiciens calculeraient l’écoulement à la main, sous la direction d’un « chef d’orchestre » ! [Source : F. Schuiten, Météo-France]

[1] L’OMM est une organisation des Nations Unies

[2] Le Centre Européen de Prévision Météorologique à Moyenne Echéance, situé à Reading, UK (Woods, 2005).

[3] Les radars météorologiques permettent de localiser les zones de précipitations dans un rayon de 80km environ, par un balayage tridimensionnel de l’espace renouvelé toutes les deux minutes environ.

[4] Groupe Intergouvernemental d’Experts sur le Climat, mis en place par l’ONU.

[5] El Nino est le réchauffement des eaux du Pacifique tropical est qui intervient tous les 3 à 5 ans vers Noël, avec des impacts considérables sur l’activité régionale.

[6] Les lidars météorologiques sont des instruments qui émettent un rayon laser et mesurent la lumière rétrodiffusée par l’atmosphère, sur le modèle des radars ; ils permettent de déterminer approximativement la vitesse de l’air et le contenu en aérosols dans un volume de plusieurs kilomètres autour de l’instrument.

[7] La scalabilité d’un code est sa capacité à exploiter de manière performante des calculateurs composés d’un très grand nombre de processeurs, calculant en parallèle. Les codes météorologiques les plus performants répartissent les calculs sur des dizaines de milliers de processeurs sans perte d’efficacité.

[8] On appelle Big Data (mégadonnées) l’ensemble des méthodes et outils qui permettent d’extraire des informations utiles des flux de données massifs qui circulent sur l’Internet.

[9] Public Sector Information, directive qui oblige les services publics à rendre leurs données librement accessibles aux citoyens, sauf exceptions justifiées.

[10] The WeatherCompany, basée aux USA, est la plus importante entreprise privée de météorologie au monde. Depuis début 2016, elle fait partie du groupe IBM.

L’Encyclopédie de l’environnement est publiée par l’Association des Encyclopédies de l’Environnement et de l’Énergie (www.a3e.fr), contractuellement liée à l’université Grenoble Alpes et à Grenoble INP, et parrainée par l’Académie des sciences.

Pour citer cet article : BOUGEAULT Philippe (17 octobre 2018), Introduction à la prévision météorologique, Encyclopédie de l’Environnement. Consulté le 24 avril 2024 [en ligne ISSN 2555-0950] url : https://www.encyclopedie-environnement.org/air/introduction-a-prevision-meteorologique/.

Les articles de l’Encyclopédie de l'environnement sont mis à disposition selon les termes de la licence Creative Commons BY-NC-SA qui autorise la reproduction sous réserve de : citer la source, ne pas en faire une utilisation commerciale, partager des conditions initiales à l’identique, reproduire à chaque réutilisation ou distribution la mention de cette licence Creative Commons BY-NC-SA.